컴퓨터에 의해 인간의 지능을 실현하려는 AI(인공지능) 연구는 1956년 다트머스 회의(Dartmouth Conference)에서 시작됐다고 한다. 그 후, 인간의 지능 중 중요한 부분을 차지하는 시각 기능을 컴퓨터로 실현하기 위한 연구 분야가 ‘컴퓨터 비전(CV)’으로 불리며 AI 연구 분야에서 파생된 것이 1980년경이다. CV 분야의 세계 최고봉 회의의 하나인 CVPR이 1983년에 시작되어 당초 100건 정도였던 발표 논문 수는 그 후 약 20년 동안에 5배인 500건 정도로 늘었으며, 더욱이 그 후 10년 동안에는 심층학습 등 AI 연구의 진화에 따른 연구자 대량 증가에 의해 4배인 2,000건을 넘을 정도까지 증가했다. 아직 증가세는 멈추지 않고 있다.

CV는 카메라의 각 화소에 수광되는 빛 세기의 2차원 배열에 지나지 않는 디지털 화상으로부터 피사체의 크기․형태․색깔․재질 등의 물리량 계측이나, 이름․의미․감정․의도 등과 같은 피사체의 의미나 상태의 이해․인식을 컴퓨터에 의해 실현하는 것이 목적인 기술 분야이다. 예를 들어 피사체의 길이(형상)를 계측하기 위해서는 그것을 화상의 화소수로 구하고, 그것이 실제 공간에서는 몇 미터에 해당하는지를 카메라의 공간 위치 자세나 렌즈의 초점 거리 등으로부터 계산하는, 촬영 상황의 기하학적 모델을 이용하는 것이 일반적이었다. 마찬가지로 피사체의 이름을 인식한다면 예를 들어 ‘고양이’라면, 그 귀는 삼각형이고 눈은 원형 등과 같은 특징을 기술하는 모델을 다수의 인식 대상 물체에 대해 만들고, 그 모델과 화상의 적합도로부터 피사체의 이름을 인식하는 방법을 채용하고 있었다.

이 방법에 의해 계측․인식 성능을 향상시키기 위해서는 형상 계측을 위한 기하학적 계산 ‘모델’이나 인식을 위한 물체 특징 ‘모델’을 피사체의 촬영 상황에 맞춰 충실하고 올바르게 표현할 필요가 있다. 그러나 매우 복잡한 현실 세계를 표현할 수 있는 ‘모델’을 설계하는 것은 어려워 종래에는 각각의 상황에 맞춰 설계된 ‘모델'만 이용할 수 있었기 때문에 다양한 상황에 대한 범용성이 없고 실용성이 낮았다.

따라서 ‘모델’을 이론에 기초해 설계하는 대신에 현실 세계에서 발생하는 데이터를 대량으로 수집하고, 그것을 이용해 ‘모델’을 만들자고 하는 것이 최근의 AI 발상의 원점이 된다. 즉, 다양한 상황에서 촬영한 대량의 화상 데이터에 대해 그들에 촬영되어 있는 피사체의 계측 대상이 되는 물리량이나 인식 대상이 되는 이름 등의 정답 데이터를 사전에 준비해 두고, 「입력」이 되는 화상 데이터와 「출력」이 되는 정답 데이터의 관계를 「모델화」(학습)해 그 입출력 관계를 표현하는 「모델」에 기초해 정답을 알 수 없는 입력에 대해 정답을 얻는다(추론)고 하는 (통계적) 기계학습에 기초한 접근법이다.

최근의 AI에 의한 CV의 혁신적인 발전은 대량의 대상이나 촬영 상황에 대해 다양한 입력 데이터와 정답 데이터(정답 라벨이라고도 부른다)를 수집할 수 있게 된 것, 그리고 많은 데이터 세트가 수집 공개되어 누구나 이용할 수 있게 되면서 이루어진 것이다. 또한 데이터 세트의 입출력 관계를 모델화(학습)해 임의의 데이터에 대해 정답을 얻는(추론) 알고리즘이 크게 진보한 것도 큰 요인이 되고 있다.

이 글에서는 AI를 활용해 카메라로는 직접 센싱할 수 없는 물리량, 물체의 명칭, 상태나 자세 등을 추정하는 사례와 카메라로는 직접 촬영할 수 없는 화상을 생성하는 사례에 대해 소개하고, AI가 종래에는 불가능했던 화상 센싱을 실현하는 가능성을 보여주고자 한다.

화소마다의 물리량과 의미의 센싱

앞에서 말한 바와 같이 카메라에 의해 얻어지는 화상으로는 각 화소의 2차원 위치와 그 위치에서 화상 센서에 의해 계측된 휘도값밖에 얻을 수 없다. 당연하지만 그 화소가 촬영한 대상의 표면상 점까지의 거리(안길이 방향의 깊이 : Depth값)를 직접 추정하는 것은 이론상 불가능하다.

이와 같이 카메라에 의한 화상 취득만으로는 얻을 수 없는 촬영 대상까지의 Depth 등을 추정하기 위해 고전적인 CV에서 채용되어 온 대표적인 방법이 스테레오법이다. 이것은 1대의 카메라로는 Depth를 얻을 수 없으므로 시점 위치가 다른 2대의 카메라로 촬영한 스테레오 화상 페어를 이용해 물체의 동일 점이 화상에 촬영된 2차원 위치로부터 삼각측량 원리에 의해 그 점의 Depth값을 추정하는 것이다. 한편, 카메라로부터 적외광을 조사해 빛이 물체까지 오가는 시간(TOF)을 화소마다 계측하거나, 특정의 공간적인 패턴을 투영해 그 패턴의 변동을 이용하거나 해서 Depth값을 얻는 거리 카메라도 이용되어 왔다.

이들은 모두 카메라 촬영 시의 3차원적 기하 이론이나 빛의 속도와 도달 시간의 관계와 같은 이론적인 뒷받침이 있는 원리에 기초해 화상 각 화소의 물체 표면상까지의 거리를 계측하는 기법이다.

이것에 대해 실제로 존재하는 다양한 대상 신에 대해 휘도(RGB값) 화상과 거리(Depth값) 화상의 세트를 대량으로 수집해 RGB 화상을 입력으로 해서 Depth 화상을 출력하는 입출력의 관계를 기계학습에 의해 모델화하고, 그 AI 모델에 임의의 RGB 화상을 입력하면 그것에 대한 Depth 화상을 추론할 수 있다는 것이 CNN-MonoFusion 등에 의해 제시되어 있다. 화소의 RGB값과 그 화소가 포착한 공간의 1점까지의 Depth값을 관련짓는 물리적 이론은 존재하지 않기 때문에 RGB값으로부터 Depth값을 계측하는 것은 일반적으로는 완전히 불가능하다. 그런데 이들 관계를 실제로 수집한 대량의 실제 데이터로부터 학습한 AI 모델을 이용함으로써 불가능했던 RGB값으로부터 Depth값을 계측하는 것이 가능해졌다. 이것은 대량의 데이터를 학습한 AI 모델이 불가능을 가능하게 하는 것을 보여주는 하나의 전형적인 사례이다.

이 AI 모델을 이용한 계측 기법의 핵심은 어떻게 대량의 데이터를 수집할 수 있는지와 그러한 대량 데이터로부터 어떻게 효과적으로 학습․추론할 수 있는 AI 모델을 설계할 수 있는지에 있으며, RGB 화상으로부터 Depth 화상을 추정한다는 문제 설정으로 한정해도 많은 방법이 연구되고 있다. 그 대표적인 예로는 관광지 등을 촬영한 인터넷 상에 있는 대량의 화상군으로부터 3차원 형상을 복원해 각 화상에 대한 Depth 화상을 생성함으로써 대량의 RGB 화상과 그것에 대응하는 Depth 화상 페어를 수집하고, 그것에 기초해 RGB 화상으로부터 Depth 화상을 추론하는 AI 모델 ‘MegaDepth’가 있다.

위에서 말했듯이 화소값에서 직접 구할 수 없는 값을 화소마다 추정하기 위해 대량 데이터에 의해 학습된 AI 모델을 이용한 예로서, 입력 화상의 화소마다 그 화소가 속한 물체 명칭 라벨(예를 들어 침대, 테이블, 벽, 바닥, 의자, 냉장고 등)을 추정하는 기술이 있다. 이것은 ‘시맨틱 세그멘테이션(Semantic Segmentation)’으로서 활발히 연구되어 온 것으로, 대량의 RGB 화상이나 Depth 화상에 대해 화소마다 정답의 명칭 라벨을 가지는 화상을 사전에 수집해 두고, 그들에 의해 학습한 AI 모델을 이용해 입력 화상으로부터 각 화소의 명칭 라벨을 추정한다.

여기서도 RGB값이나 그 화소가 나타내는 공간 점까지의 Depth와 물체 명칭이라는 인간이 정의한 시맨틱스를 관련짓는 이론은 일반적으로는 존재하지 않지만, 대량의 학습 데이터 세트에 포함된 다양한 물체의 명칭과 그 RGB값이나 Depth의 2차원 분포에 숨어 있는 잠재적인 관계가 AI 모델에 의해 학습되며, 이 AI 모델을 이용함으로써 RGB 화상이나 Depth 화상으로부터 물체의 명칭을 추론할 수 있다. 그림 1에 SLAM 기술에 의해 생성한 3차원 신의 구조를 나타내는 3D 맵에 대해 시맨틱 세그멘테이션을 이용해 명칭 라벨마다 분할한 3차원 맵으로 표시한 예를 나타냈다.

물체 상태 등의 센싱

입력 화상의 화소마다 Depth값이나 물체 명칭 라벨을 추정하는 위의 예와는 달리, 입력 화상으로 촬영되고 있는 대상 물체의 상태 등을 나타내는 다차원 데이터를 AI 모델에 의해 추정할 수도 있다. 그 예로는 화상으로부터 인간 자세를 계측(손․발 등 다관절의 관절 위치와 각도 데이터의 계측)하는 것이 있다. 이것을 실현하는 대표적인 장치가 계측 대상의 몸에 여러 개의 광학 마커를 설치하고 마커 위치를 검출해 대상 인물의 자세를 계측하는 광학적 모션 캡처 장치이다. 이것은 스포츠 동작 해석 등에 활용되는데, 당연하지만 카메라로 촬영할 수 있는 공간에서만 이용할 수 있다.

이 자세 추정을 모든 일상생활 공간에서 상시 실시함으로써 그 상시 계측 데이터를 건강 증진이나 재활에 유용하게 사용할 수 있다. 자세 계측을 언제 어디서나 할 수 있도록 계측 대상 인물에 카메라를 부착하고 동작에 따라 움직이는 카메라에 촬영된 영상으로부터 그것을 부착한 인물의 자세를 추정하는 기법이 제안되고 있다.

카메라에 촬영되는 영상에는 거의 계측 대상이 되는 인물의 몸은 촬영되지 않고 대부분은 그 동작에 따라 화상 내에서 주위 환경이 움직이는 영상이 촬영될 뿐이지만, 인물의 동작에 따른 카메라의 움직임은 동작 중인 인물 자세와의 사이에 어떠한 관계가 있다. 만약 이 관계를 정확하게 정식화할 수 있다면, 이 정식화에 기초해 촬영된 영상으로부터 인물 동작 자세를 구할 수 있을지도 모른다.

그러나 인체 자세는 10개 이상이나 되는 다관절 위치와 자세로 구성된 다차원 벡터 데이터로 표현되고, 그에 따른 카메라 위치 자세는 6자유도가 되므로 이들 관계를 정식화해 그 관계를 화상으로부터 추정하는 것은 간단한 일이 아니다.

이에 대해 Yuan 등은 임의의 인체 자세로부터 그 인체에 부착된 카메라 화상을 쉽게 CG 합성할 수 있다는 점에 착안해 다양한 자세에 대한 카메라 화상 세트를 대량으로 생성하고 그들의 관계를 AI 모델로 학습, 학습된 AI 모델을 이용해 실제 카메라 화상으로부터 그것을 부착한 인체의 자세를 추정할 수 있음을 보여줬다.

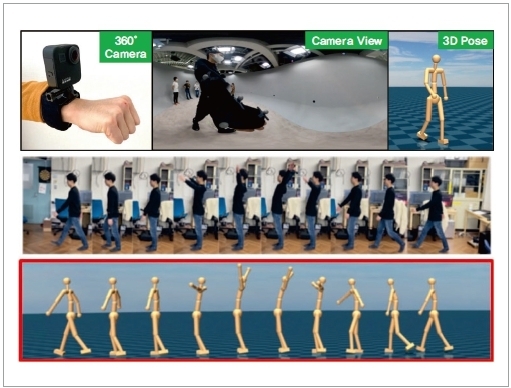

필자 등은 동일한 접근법을 이용해 손목에 부착한 카메라에 의해 촬영되는 화상으로부터 그것을 부착한 인물의 동작을 계측하기 위해 촬영되는 화상을 입력으로 하고, 그 때의 다관절 위치와 각도(동작 데이터)를 출력으로 하는 AI 모델을 구축하는 기법을 제안했다. 그림 2에 이 기법의 입력 화상 예(Camera View)와 출력 데이터로 얻어지는 동작 데이터(3D Pose)의 예를 나타냈다. 여기서는 손목 카메라에 일부 촬영되는 인체 영역의 형상과 그것에 대응하는 인물 자세의 관계를 CG 합성해 수집한 대량의 데이터 세트에 기초해 학습된 AI 모델을 이용함으로써 동작 자세 추정을 실현하고 있다.

카메라로 촬영할 수 없는 화상의 생성

지금까지 소개한 바와 같은 물리량이나 상태를 추정하는 화상 센싱에 대해 실제로는 카메라로 촬영할 수 없는 새로운 화상을 생성하기 위해 AI를 활용하는 사례도 활발히 연구 개발이 추진되고 있다.

예를 들어, 실제로는 카메라의 흔들림이나 렌즈의 초점 흐려짐에 의해 열화된 화상으로부터 이러한 열화가 없는 화상(실제로는 촬영할 수 없었던 화상)을 생성하는 기술을 들 수 있다. 이 기술은 오래전부터 연구되어 왔으며, 그 표준적인 방법으로는 ‘화상의 흔들림이나 흐려짐에 의한 열화 화상은 실제로는 촬영할 수 없었던 흔들림이나 흐려짐이 없는 화상에 대해 열화 요인을 나타내는 점확산함수(PSF, Point Spread Function)를 중첩 적분한 것’이라고 수학적으로 모델화할 수 있는 것을 이용한다.

따라서 이 PSF를 어떠한 방법으로 얻을 수 있다면, 중첩 적분의 역을 계산함으로써 열화 화상으로부터 열화가 없는 화상을 복원할 수 있다. 그러나 실제로는 PSF를 얻을 수 없는 것이 대부분이다.

그래서 대상이 되는 열화를 받은 화상과 그 열화를 받지 않은 화상의 세트를 대량으로 데이터로서 취득해 두고(취득 방법은 CG로 합성한다든가, 같은 신을 흔들림이나 흐려짐이 있는 카메라와 그렇지 않은 카메라로 동시에 촬영하는 등의 방법을 생각할 수 있다), 이 대량 데이터에 의해 열화 화상과 열화가 없는 화상의 관계를 학습한 AI 모델을 얻음으로써 열화 화상으로부터 열화가 없는 화상을 복원할 수 있게 된다.

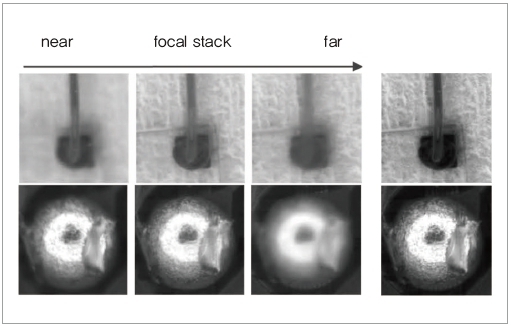

이러한 개념과 마찬가지로 화상의 일부에만 초점이 맞춰져 있고, 그 이외의 영역에서 흐려짐이 발생한 복수의 화상군(포컬 스택)으로부터 화상 전체에 걸쳐 흐려짐이 없는 화상(전초점 화상)을 생성하기 위해 AI를 이용한 기술이 있다.

고전적인 방법에서는 화상의 각 위치에서 포컬 스택 화상군 중 어느 화상에서 가장 초점이 맞는지(합초도)를 판정하기 위해 각 위치 주변의 국소 패치 화상을 이용해 고주파 성분의 에너지 크기를 이용하는 것이 일반적이었지만, 모든 위치에서 이 에너지를 타당하게 평가하는 것이 어려운 경우가 많아 결과적으로는 기대할 만한 것은 없었다. 그래서 다양한 3차원 형상을 가진 신을 가정해 각각에 대해 포컬 스택 화상군과 그것에 대해 정답이 되는 합초도 세트를 대량으로 CG를 이용해 생성해 두고, 그 데이터로부터 AI 모델을 학습한다. 그리고 이 AI 모델을 이용해 임의의 신에 대해 촬영된 포컬 스택 화상군으로부터 화소 위치마다 초점이 가장 잘 맞은 화상으로부터 화소값을 수집함으로써 모든 위치에 초점이 맞는 화상을 얻을 수 있다. 그림 3은 공업 부품에 대한 현미경 화상(화상의 일부에만 초점이 맞는다)을 다수 수집해 AI에 의해 모든 점에 초점이 맞춰져 있는 화상을 생성한 사례를 보여준다.

AI 모델은 동일한 피사체에 대해 복수의 위치 자세에서 촬영한 다시점 화상으로부터 새로운 시점의 화상을 생성하는 기술에도 활용되어 고전적인 방법으로는 실현할 수 없었던 화질의 화상 생성이 가능해졌다.

이 브레이크 스루를 만든 기법이 NeRF라고 불리는 방법이다. 고전적인 방법에서는 다시점 화상군을 입력으로 하고 촬영 대상 신의 3차원 형상을 폴리곤 메시는 볼륨 데이터로서 명시적으로 표현한 3차원 모델을 복원해 입력 화상군과 3차원 모델을 이용한 CG 합성에 의해 임의로 설정할 수 있는 새로운 시점의 화상을 생성하고 있었다.

이에 대해 NeRF에서는 대상 신의 3차원 형상을 AI 모델인 뉴럴 네트워크로 표현한다. 이 뉴럴 네트워크는 대상 3차원 공간 중의 격자 모양으로 배치된 3차원 점의 각 위치 (X, Y, Z)와 그 3차원 점을 관찰하는 시점의 방향 (θ, ϕ)을 입력하면, 그 방향에서 관찰했을 때의 그 3차원의 투명도 σ와 RGB값을 출력하도록 구성되어 있다. 그리고 취득된 다시점 화상을 학습 데이터로 하고, 학습 데이터와 동일한 출력이 되도록 학습된 AI 모델을 이용해 임의의 시점 방향에서 관찰되는 모든 3차원 점의 σ와 RGB값을 가산함으로써 임의의 새로운 시점의 화상을 생성하는 것이다.

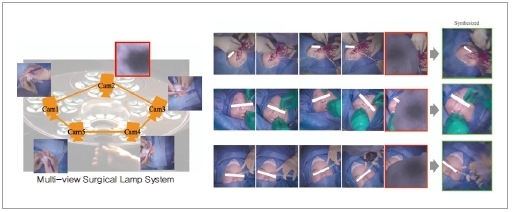

그림 4에 NeRF를 발전시킨 Generalizable NeRF Transformer(GNT)에 의해 새로운 시점의 화상을 생성한 예를 나타냈다. 여기서는 필자 등이 게이오대 의학부와 공동으로 연구 개발하고 있는 다시점 카메라 탑재형 무영등에 의해 다시점 촬영된 화상을 이용하고 있다. 그림 4의 예는 수술자의 머리부 등에 의해 수술야가 차폐된 경우에 다른 카메라를 이용해 차폐된 시점의 영상을 생성한 예를 나타낸다.

또한, 이 다시점 카메라 탑재 무영등은 수술자의 머리부 등으로 한 대의 카메라에 의한 촬영으로는 수술야를 상시 촬영할 수 없는 문제에 대해, 여러 대의 카메라로 동시 촬영함으로써 어떤 카메라에는 차폐 없이 수술을 계속 기록할 수 있다는 가정을 바탕으로 개발한 것이다. 위와 같은 새로운 시각의 화상을 생성하는 경우에는 반드시 실제 상황을 재현할 수 있다는 보장이 없기 때문에 실용적으로는 이들 여러 대의 카메라에서 차폐가 없는 카메라만을 자동 선택해 항상 차폐가 없는 수술 영상 기록을 만들고 있다. 이 자동 선택에는 AI 모델이 이용되고 있다.

맺음말

이 글에서는 카메라에 의해 촬영된 화상을 입력으로 해서 촬영 대상에 관한 물리량을 계측하거나 촬영 대상에 대해 실제로는 촬영할 수 없는 화상을 생성하거나 하기 위한 AI 활용 사례에 대해 소개했다.

AI를 사용하지 않은 종래의 컴퓨터 비전 기술에서는 촬영 화상(입력 데이터)과 그것에 의해 계측하고 싶은 물리량이나 생성한 화상(출력 데이터)의 상호 관계를 밝힘으로써 입력으로부터 출력을 얻기 위한 알고리즘을 구축했었다. 그러나 현실적으로는 입출력의 상호 관계를 명확하게 밝히기가 어렵고, 명확하게 하기 위해 입출력의 상호 관계를 단순화해 표현할 수밖에 없는 경우가 많았다.

이에 대해 AI에 의한 방법에서는 위와 같은 입출력의 상호 관계를 명확하게 밝힐 필요 없이 실제로 수집하거나 컴퓨터 시뮬레이션을 통해 계산하거나 해서 얻은 대량의 입출력 데이터(학습 데이터)를 이용해 AI 모델을 학습하고, 이 학습이 끝난 AI 모델에 입력 데이터인 촬영 화상을 입력함으로써 출력을 얻을 수 있다. 따라서 AI에 의해 화상으로부터 계측이나 인식을 하는 CV 기술이 현격하게 발전해, 이전에는 불가능하다고 생각되었던 것이 현재는 가능해지고 있다. 이것은 기계학습 알고리즘의 진보와 그 학습에 사용되는 대량의 데이터를 수집할 수 있고, 기계학습 프로그램이나 그 학습을 위한 데이터를 인터넷에 의해 많은 기술자․연구자가 간단히 이용할 수 있게 됐기 때문이다.

이 글에서는 다루고 있지 않지만, 이와 같이 프로그램이나 데이터가 많은 기술자나 연구자에게 이용될 때에 이들의 라이선스 등의 권리 문제나 데이터에 포함된 개인정보 등의 프라이버시 문제는 때로는 AI 기술의 발전을 저해할 가능성도 있어 앞으로 AI가 널리 이활용되기 위해 이러한 문제를 원활히 해결하는 것도 중요한 과제가 되고 있으며, 이 부분에 대한 중요성도 의식하면서 AI가 인간 사회의 미래를 위해 활용되는 것이 바람직하다.