기존 GPU 인스턴스 대비 최대 20배 향상된 연산 성능 및 11배 높은 메모리 용량 제공

아마존웹서비스(AWS)가 초거대 생성형 AI 훈련과 추론을 위한 차세대 인프라로, 엔비디아의 최신 슈퍼칩 ‘그레이스 블랙웰(Grace Blackwell)’ 기반의 P6e-GB200 울트라서버를 공개했다. 이는 기존 GPU 인스턴스 대비 최대 20배 향상된 연산 성능과 11배 높은 메모리 용량을 제공하며, AWS 역사상 가장 강력한 GPU 기반 인프라로 평가된다.

이번에 함께 공개된 P6-B200 인스턴스는 중대형 AI 워크로드에 유연하게 대응할 수 있도록 구성됐다. 두 제품 모두 엔비디아 블랙웰 GPU를 중심으로 설계됐으며, 대규모 AI 시스템과 실시간 고성능 추론이 요구되는 에이전틱 AI 시스템을 위한 솔루션이다.

P6e-GB200 울트라서버는 최대 72개의 엔비디아 블랙웰 GPU를 NV링크로 연결해 하나의 컴퓨팅 유닛처럼 동작하며, FP8 연산 기준 360페타플롭스의 성능과 총 13.4테라바이트의 고대역폭 GPU 메모리를 제공한다. 이와 함께 4세대 EFA 네트워크를 통해 초당 최대 28.8테라비트의 대역폭을 구현했다.

반면, P6-B200 인스턴스는 8개의 블랙웰 GPU와 1.4TB GPU 메모리, 5세대 인텔 제온 스케일러블 프로세서를 탑재해, 다양한 AI 학습 및 추론 환경에서 높은 호환성과 효율성을 제공한다. 기존 세대 인스턴스 대비 최대 2.25배 향상된 연산 성능과 향상된 네트워크 처리 능력을 갖췄다.

초대형 언어모델처럼 조 단위 파라미터를 처리하는 워크로드에는 P6e-GB200이 적합하다. GB200 NVL72 아키텍처는 통합된 메모리 공간과 NV링크 기반 저지연 구조를 통해, 전문가 혼합 모델과 초대형 컨텍스트 윈도우 처리에 최적화된 추론 환경을 제공한다. P6-B200 인스턴스는 기존 x86 환경에서 GPU 워크로드를 이식하고자 하는 기업에 유리하다. 코드 변경을 최소화하면서 최신 GPU 인프라로의 전환이 가능하며, 다양한 AI 소프트웨어 스택과의 호환성도 뛰어나다.

두 인프라 모두 AWS의 6세대 니트로 시스템을 기반으로 구동된다. 이는 고객 데이터에 대한 접근을 원천 차단하고, 시스템 중단 없이 펌웨어 업데이트를 지원하는 라이브 업데이트 기능을 제공한다. 이러한 보안성과 운영 안정성은 특히 민감한 데이터 환경에서 AI 워크로드를 운영하는 기업에 중요한 선택 기준이 된다.

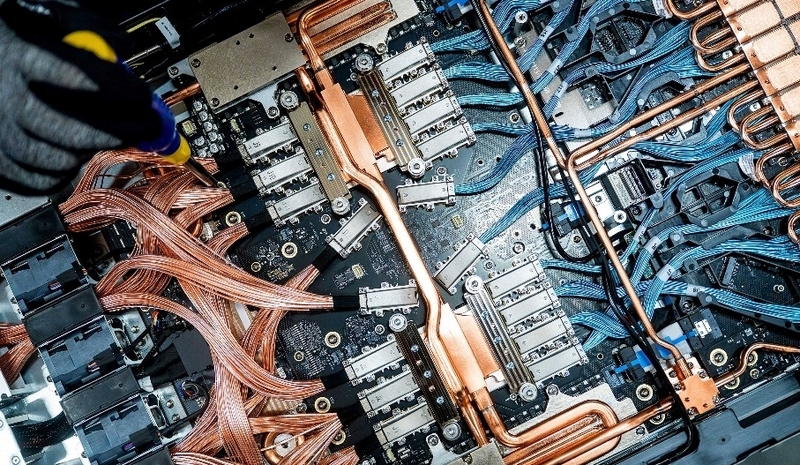

P6e-GB200은 액체 냉각 방식을 채택해 높은 밀도의 GPU 환경에서도 안정적인 열 관리를 가능하게 한다. 공랭 방식의 P6-B200과 혼합 운영이 가능한 유연한 인프라 구성이 가능해, 데이터센터의 물리적 제약을 최소화한다. 또한, EC2 울트라클러스터를 기반으로 대규모 GPU 노드 간 통신을 최적화해, 고속 분산 학습에 유리한 구조를 갖췄다.

AWS는 두 인프라를 세이지메이커 하이퍼팟과 아마존 EKS, DGX 클라우드 등 다양한 방식으로 배포할 수 있도록 구성했다. 세이지메이커 하이퍼팟은 자동화한 GPU 클러스터 운영과 예측 가능한 학습 계획을 제공하며, 오류 복구 및 GPU 상태 모니터링 기능을 갖춘 포괄적인 관리 환경을 지원한다.

EKS 기반의 쿠버네티스 운영 환경에서도 P6e-GB200과 P6-B200 인스턴스 모두 활용 가능하며, 토폴로지 인식 기능을 통해 울트라서버 ID에 따라 워크로드를 최적화해 배치할 수 있다. P6e-GB200 울트라서버는 엔비디아 DGX 클라우드를 통해서도 제공될 예정으로, 전문화된 AI 소프트웨어 스택과 엔비디아의 기술 지원을 바탕으로 AI 프로젝트의 속도와 효율성을 높일 수 있다.

헬로티 서재창 기자 |