테크노트 KAIST, AI가 판단하는 방식 첫 시각화...XAI 새 지평 열어

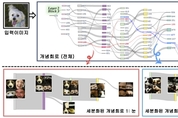

딥러닝 기반 이미지 인식 기술이 빠르게 고도화되고 있지만, AI가 내부에서 어떤 기준으로 이미지를 보고 판단하는지는 여전히 명확히 설명하기 어려운 영역으로 남아 있다. 특히 대규모 모델이 ‘고양이 귀’, ‘자동차 바퀴’와 같은 개념을 어떤 방식으로 조합해 결론을 내리는지는 오랫동안 해결해야 할 주요 과제로 제기돼 왔다. KAIST는 김재철AI대학원 최재식 교수 연구팀이 인간이 이해할 수 있도록 AI의 판단 근거를 시각적으로 보여주는 설명가능성(XAI) 분야에서, 모델 내부의 개념 형성 과정을 회로(circuit) 단위로 시각화하는 새로운 XAI 기술을 개발했다고 26일 밝혔다. 이번 연구는 “AI가 어떻게 생각하는가?”라는 질문에 구조적 접근을 가능하게 한 중요한 진전으로 평가된다. 딥러닝 모델 내부에는 인간의 뇌처럼 뉴런(Neuron)이라는 기본 계산 단위가 존재한다. 뉴런은 귀 모양, 색상, 윤곽선처럼 이미지의 작은 특징을 감지해 다음 단계로 신호를 전달하는 기능을 한다. 반면 ‘회로(circuit)’는 여러 뉴런이 서로 연결돼 하나의 개념을 함께 인식하는 구조로, 예컨대 ‘고양이 귀’를 인식하기 위해 귀 윤곽·삼각형 형태·털 패턴 등을 감지하는 뉴런들이